Indeksering i Googles søgeresultater – undgå digital usynlighed

Indeksering af din hjemmeside er en helt grundlæggende forudsætning for synlighed i Googles søgeresultater.

Hvis Google ikke kan crawle og indeksere din hjemmeside, kan de ikke vise din hjemmeside frem for dine kunder.

Og det skal du selvfølgelig undgå for alt i verden.

I dette indlæg får du simple og konkrete eksempler på almindelige indekseringsproblemer – og tilsvarende løsninger.

Indholdsfortegnelse

Først og fremmest… Er din hjemmeside indekseret i Googles søgeresultater?

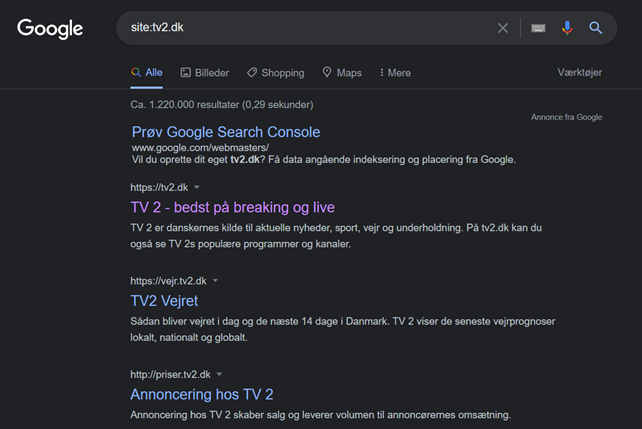

For at se om dit website er indekseret i søgemaskinerne, kan du åbne Google og indtaste: “site:www.ditdomænenavn.dk”.

For TV2 ser det således ud:

Når du skriver dit hjemmesidenavn med ”site:” foran, vil Google nemlig liste alle de sider, de har indekseret fra dit website.

I TV2’s tilfælde er det over en million sider.

Du kan også teste det ved at søge på et længere citat fra den enkelte underside, du vil tjekke.

Det er helt normalt, hvis nogle af dine sider ikke er indekseret – det kan have forskellige årsager, som jeg vil komme ind på senere.

Men hvis ingen af dine sider er indekseret, selvom din hjemmeside er live og har været det i et stykke tid, er der et helt fundamentalt problem.

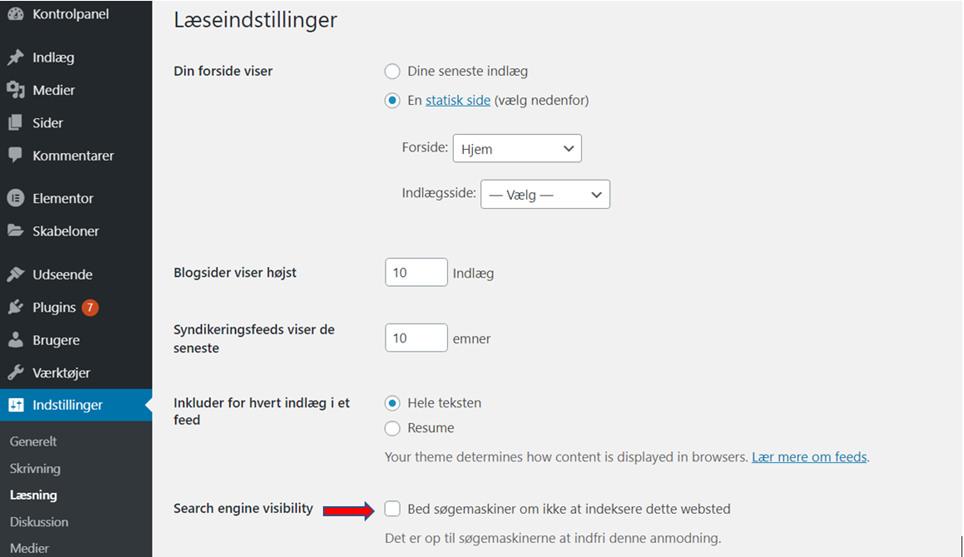

Her vil årsagen højest sandsynligt ligge i, at du har blokeret adgangen for søgemaskiner. Hvis du har en WordPress-side, skal du være opmærksom på “Indstillinger” – “Læsning” i din backend:

Hvis boksen markeret med den røde pil er slået til, skal du slå den fra med det samme.

Hvad betyder indeksering?

Indeksering betyder, at Google inkluderer din hjemmeside i deres indeks af hjemmesider. Det sker, når Google har crawlet din hjemmeside. Googles crawler hedder Googlebot.

Google har et indeks af hjemmesider, så de kan vurdere, hvilke hjemmesider der skal rangere, når vi bruger deres søgemaskine til at lære noget nyt eller købe noget.

Google crawler og indekserer jævnligt de hjemmesider, de kan få adgang til, og som har en vis relevans for- og er gavnlige for internettet. Google udelukker altså så vidt muligt alle spam- og scam-sider fra deres indeks.

Hvordan får du Google til at crawle og indeksere din hjemmeside?

Din hjemmeside bliver crawlet, når Googlebot kommer forbi den. Det kan f.eks. ske, hvis din hjemmeside bliver linket til fra en anden hjemmeside, og Googlebot har fulgt dette link.

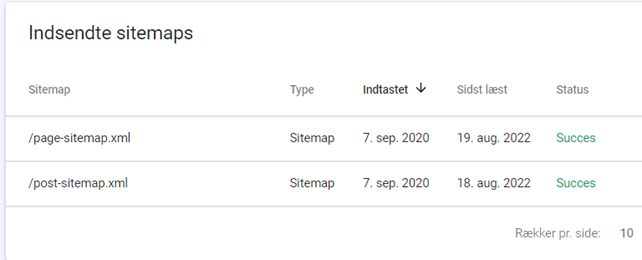

Det kan også ske, hvis du har indsendt et såkaldt ”sitemap” af din hjemmeside til Google. Det kan du gøre i Google Search Console. Se screenshot:

Hvis du har WordPress og bruger det meget populære plugin Yoast, vil det automatisk generere et sitemap til dig. Du kan finde dit sitemap ved at skrive ”www.ditdomænenavn.dk/sitemap.xml” i søgefeltet.

Hvad gør du, hvis kun et par af dine sider bliver crawlet og indekseret?

Hvis Google ikke crawler hele din side, kan du starte med at kigge på din hjemmesidestruktur- og opbygning.

Hvis din hjemmeside er meget tung, er bygget mangelfuldt op eller har meget lang loadtid, kan Googlebot vælge at lade være med at crawle og indeksere den.

Manglende crawl og indeksering kan også skyldes et problem med din interne linkstruktur.

Lad os antage, at du har fået et link til din forside, og Googlebot lander hos dig igennem det link. Hvis du ikke har en god intern linkstruktur, vil du ikke få crawlet resten af dine sider, fordi Googlebot ikke har flere links at følge.

Hvorfor har Googles crawler ikke indekseret alle mine sider? – Om crawlbudget

Google har en bestemt mængde resurser afsat til crawl af hver enkelt hjemmeside. Denne mængde resurser kaldes et ”crawlbudget”.

Googlebot prioriterer sit crawlbudget. Hvis du har en lille side med få besøgende, er crawlbudgettet tilsvarende lavt. Og hvis din side får nul besøgende, er budgettet endnu lavere.

Omvendt er der et højt crawlbudget afsat til hyppigt at crawle og indeksere din hjemmeside, hvis den er populær og du jævnligt tilføjer nyt indhold.

Læs Googles egen kilde om crawlbudget.

Hvis din hjemmeside samtidig har en langsom loadtid, og din interne linkstruktur er dårlig, vil det tage Googlebot flere forsøg at få indekseret hele din side.

Hvis du har en stor hjemmeside, og din interne linkstruktur er dårlig, eller du ikke har styr på duplicate content (f.eks. at du har både http- og https-versionen af din hjemmeside aktiv), kan Google løbe tør for crawlbudget, før dine ønskede sider er crawlet.

Du kan gøre følgende for at optimere dit crawlbudget:

- Udgiv nyt indhold regelmæssigt – og slet alt indhold, der ingen værdi skaber for brugeren.

- Benyt dig af strategisk ekstern linkbuilding, så Googlebot naturligt kommer forbi dig oftere.

- Undgå duplicate content (identisk indhold).

- Undgå døde links, der fører til 4xx-sider.

- Hav en god intern linkstruktur, der er nem og intuitiv for Googlebot at følge.

Bør du udelukke nogen af dine sider fra at blive indekseret?

Det er sjældent, at du aktivt bør blokere nogle af dine sider fra at blive indekseret, men det kan ske. Og Google kan også selv aktivt fravælge at indeksere nogle af dine sider, f.eks. hvis du har to sider med duplicate content.

Hvis du har en side, som du fortæller Google, at Google ikke skal have i sit indeks, kan det også tolkes som et dårligt tegn. For hvad har du at skjule?

Hvis siden ikke er værd at indeksere, er den vel heller ikke værd at have på din hjemmeside?

Du bør kun fravælge indeksering på de sider, som Googlebot ikke skal bruge crawlbudget på (og det vil ofte kun være relevant, hvis du har sider med duplikeret indhold eller mange tusind URL’er med få besøgende).